如何在DigitalOcean的H100 GPU服务器上运行DeepSeek R1 模型

在这篇两部分系列文章的第一部分中,我们将展示如何在 DigitalOcean 的 GPU Droplets 上,通过 Ollama 来运行这些模型。你会学到如何设置 GPU Droplet、安装 Ollama,以及如何开始用 Deepseek R1 进行推理。

为什么应尽快部署DeepSeek?深度解析DeepSeek 成本与利润率

DeepSeek官方近期公布的推理服务数据,为我们揭示了其在硬件选型、资源调度和盈利模式方面的诸多关键信息,其盈利能力更是让人关注。同时,这背后也引发人们的思考,如果自己的公司同样部署了DeepSeek模型,那么是否也能复刻同样或相近的利润率呢?

卓普云携手DigitalOcean亮相香港Consensus大会:以技术赋能全球Web3生态

Consensus 大会首度落地香港,彰显了亚洲市场在 Web3 全球化进程中的战略地位。香港特区政府代表在开幕致辞中强调,香港将通过政策支持与技术创新,打造开放、合规的数字资产交易环境。这一背景下,DigitalOcean 与其中国区独家战略合作伙伴卓普云的参展,不仅展示了 DigitalOcean 在云计算基础设施领域的合作成果,更传递出对 Web3 市场长期布局的信心。

H200 GPU裸机服务器上线!可更好支持DeepSeek满血版

DigitalOcean 隆重推出基于 NVIDIA HGX H200 AI 超级计算平台的裸机服务器,专为高性能AI工作负载而生。无论你是在训练大规模模型、优化AI系统,还是在执行实时推理任务,NVIDIA H200 GPU都能提供强大的性能支撑和灵活的应用场景,加速你的AI应用进程

显存、带宽与CUDA核心的优先级分析,Deepseek 大语言模型部署技术选型

本文将结合模型架构特性与硬件运行原理,系统分析显存容量、显存带宽、CUDA核心三大关键指标的优先级关系,为开发者提供可落地的技术选型框架。

个人和企业必看,DeepSeek从1.5B到671B模型的选型与部署指南

个人开发者、创业团队,该在DeepSeek-R1的1.5b、7b、8b、14b、32b、70b和671b几个版本中怎么选?对应不同版本模型需要什么配置,会付出什么样的成本?很多人可能还不太清楚。我们在这篇文章中逐一分析解答。

人人皆可创建自己的AI应用:DigitalOcean GenAI平台正式上线

DigitalOcean GenAI 平台现已全面开放——这是一个强大且易用的解决方案,将彻底改变团队创建和部 […]

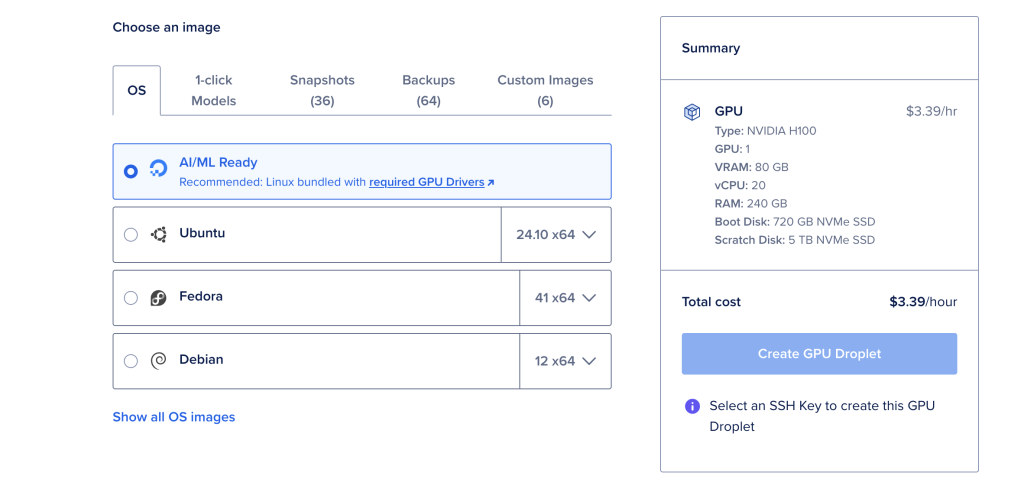

使用DigitalOcean GPU Droplets一键部署DeepSeek AI模型

DeepSeek R1开源高级推理模型现在可以通过 DigitalOcean 的 GPU Droplet 1-Click 模型进行一键部署。您现在可以直接在 DigitalOcean 的云控制台中启动 DeepSeek R1,通过极简的过程进行部署。

DeepSeek-V3 模型到底强在哪,以及如何运行它?

本文将探讨最新的大型语言模型DeepSeek V3的特性,以及与其它模型的指标对比。然后在最后,我们在 H800 GPU上运行 DeepSeek v3,让我们来体验一下。

GPU 服务器遇到“黑五”,H100 仅需2.24 美元每小时!

NVIDIA H100 GPU 是目前市场上最先进的 AI 研发必备“加速器”之一,它在性能上超越了前一代的A […]