如何在AMD MI300X 服务器上部署 DeepSeek R1模型?

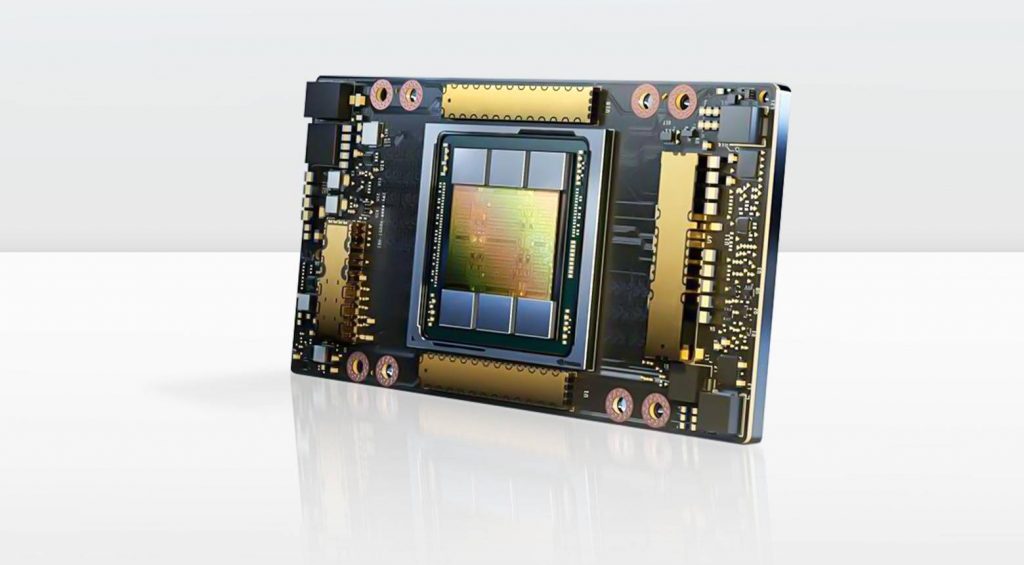

在本博文中,我们将探讨DeepSeek-R1如何在AMD Instinct™ MI300X GPU上实现卓越性能,并与H200进行性能对比。

H200 vs. H100 vs. AMD MI300X GPU,DeepSeek模型部署该怎么选?

我们将通过本文对产品规格、训练与推理表现等方面的数据进行比较,帮助大家全面了解 NVIDIA H200、H100 与 AMD Instinct MI300X 三款 GPU 的特点,为服务器选型提供决策依据。本文中引用的数据均来源于公开报道和权威测试报告。

Ex-Human:在DigitalOcean云平台之上,构建下一代 AI 数字人

Ex-Human 正在通过创造极具吸引力和富有同理心的人工智能角色,重新定义人们与人工智能的互动方式。该公司由 Artem Rodichev 创立,让用户能够通过文本、图像、视频和音频创建能互动的独一无二的数字人物。凭借每月超过一百万的活跃用户和五百万个定制创建的角色,Ex-Human 正在迅速塑造人工智能驱动的陪伴关系的未来。

极致性价比!DigitalOcean 发布 AMD Instinct MI300X GPU 裸金属服务器

DigitalOcean 宣布现已提供 AMD Instinct MI300X GPU,并搭载 ROCm 软件,以支持用户的 AI 任务。

仅1.99 美元/小时,NVIDIA H100x8 服务器再降价

DigitalOcean 近期调整了基于 NVIDIA H100x8 的 GPU Droplet 云服务的定价。预留实例(一年期合约)的价格已从原先的 2.5 美元降至 1.99 美元/GPU/小时。

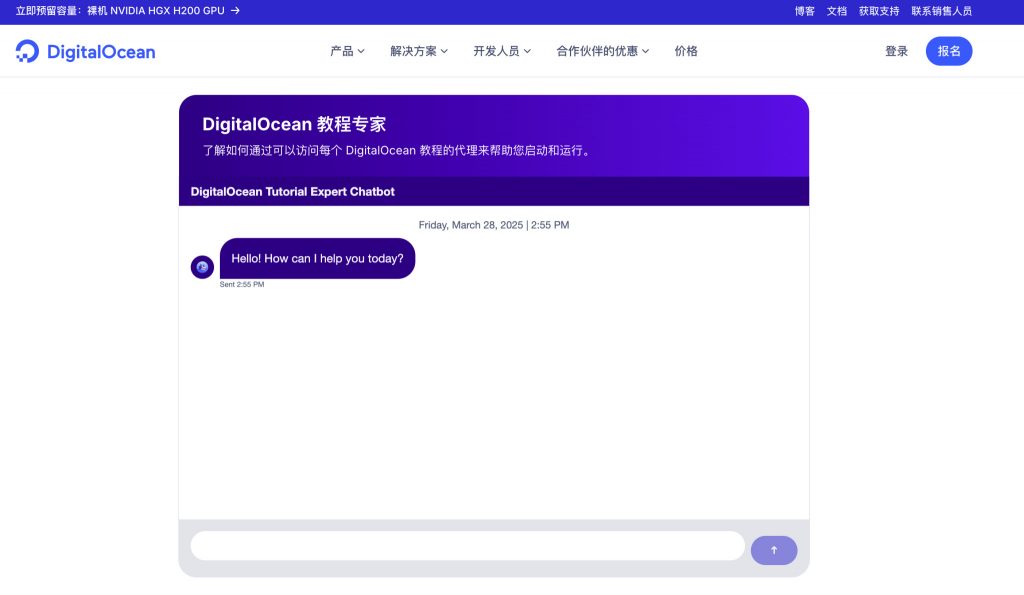

基于 Concrete5 的网站添加 AI 聊天机器人

我们将在接下来的内容里,一步步带着你为一个基于 Concrete5 的网站添加 AI 聊天机器人,让这个机器人提供7×24小时客户支持、收集潜在客户信息。

H100/A100如何选?90%人忽略的选型关键:GPU内存带宽决定AI模型性能!

本文将解释 GPU 内存带宽是什么、它为什么重要,以及它如何影响深度学习工作负载。了解内存带宽可以帮助机器学习团队在 GPU 服务器时做出明智的决策。

Manus火爆背后,AI Agen是什么?它怎样影响普通人和企业?

什么是AI Agent?它会怎样改变普通人的生活?它会将会给企业和不同行业带来什么样的影响呢?企业要开发一个AI Agent到底难在哪儿?我们将用这一篇文章,给大家简要讲一讲。

NVIDIA H200 GPU 比 H100 强在哪?

随着人工智能领域的增长,开发越来越强大的GPU的努力依然在持续,以满足用户在云端的需求。每天都有越来越多的相关 […]

用不了 Manus ?其实你能用 DeepSeek 做个自己的 AI 智能体

最近,Manus火出圈了。有不少“报道”称它是全球首款具备通用能力的AI智能体。Manus 的官方把它定义为“ […]